Auch Unternehmen im Visier

Wie perfekt gefälschte Welten funktionieren, zeigt ein Beispiel aus Hongkong. Dort saß ein Angestellter eines internationalen Konzerns einer komplett gefälschten Videokonferenz mit mehreren Mitarbeitenden seines Unternehmens auf – alles Fake. Die vermeintlichen Kollegen brachten ihn dazu, fast 24 Millionen Euro an die Drahtzieher zu überweisen. Diese hatten offenbar zuvor interne Videoaufzeichnungen des Unternehmens gehackt und sie mit KI-generierten Stimmen versehen. Dass er der einzig echte Mensch in der Konferenz war, bemerkte der Betrogene erst, als er danach mit seinem wirklichen Chef telefonierte.

Von solchen oder ähnlichen Szenarien könnte man in Zukunft auch hierzulande öfter hören. Im Mai hat das Bundeskriminalamt sein »Bundeslagebild Cybercrime« für 2023 veröffentlicht. Die Zahl der Straftaten, die aus dem Ausland auf Deutschland verübt wurden, ist danach im vergangenen Jahr um 28 Prozent gestiegen. Durch die Angriffe entstand ein Schaden von 206 Milliarden Euro.

Desinformation ist größtes Problem unserer Zeit

»Die bedeutendsten Herausforderungen unserer Tage sind nicht der Klimawandel, der Verlust an Biodiversität oder Pandemien. Das bedeutendste Problem ist unsere kollektive Unfähigkeit, zwischen Fakten und Fiktion zu unterscheiden«, bringt es der renommierte Club of Rome auf den Punkt – jene Organisation, die vor mehr als 50 Jahren die ökologischen Folgen des Wirtschaftswachstums angeprangert hatte. Die Konsequenzen der digitalen Manipulation sind Vertrauensverlust und eine polarisierte, verunsicherte Gesellschaft, in der Menschen sich nicht mehr über grundlegende Tatsachen einigen können. Wo Vertrauen erodiert, wird eher jenen Informationen geglaubt, die die eigene Sichtweise bestätigen. Und damit schrumpft die Faktenbasis für einen demokratischen Diskurs weiter. So wundert es kaum, dass 81 Prozent der Deutschen denken, Desinformation bedeute eine Gefahr für die Demokratie und den gesellschaftlichen Zusammenhalt. Das zeigt die diesjährige Studie »Verunsicherte Öffentlichkeit« der Bertelsmann-Stiftung.

Die Ursprünge von Desinformationskampagnen verorten 67 Prozent der Befragten bei Protest- und Aktivistengruppen, 60 Prozent bei Bloggern und Influencerinnen sowie knapp die Hälfte bei ausländischen Regierungen. Die Studie erlaubt auch den Vergleich mit den USA. Dort sind die Verunsicherung über und die Wahrnehmung von Desinformation noch ausgeprägter als in Deutschland. Während sich 39 Prozent der befragten US-Amerikaner sorgen, selbst von Desinformation getäuscht zu werden, und daher Inhalte häufiger und kritischer überprüfen, glauben Deutsche fest an ihre eigene Urteilsfähigkeit: Das Risiko, sich selbst durch Desinformation beeinflussen zu lassen, bewerten nur 16 Prozent als hoch oder sehr hoch, 78 Prozent als gering. Diese Selbstsicherheit könnte sich mit den neuen Möglichkeiten durch KI als Trugschluss erweisen.

Wo KI helfen kann, Deepfakes zu erkennen

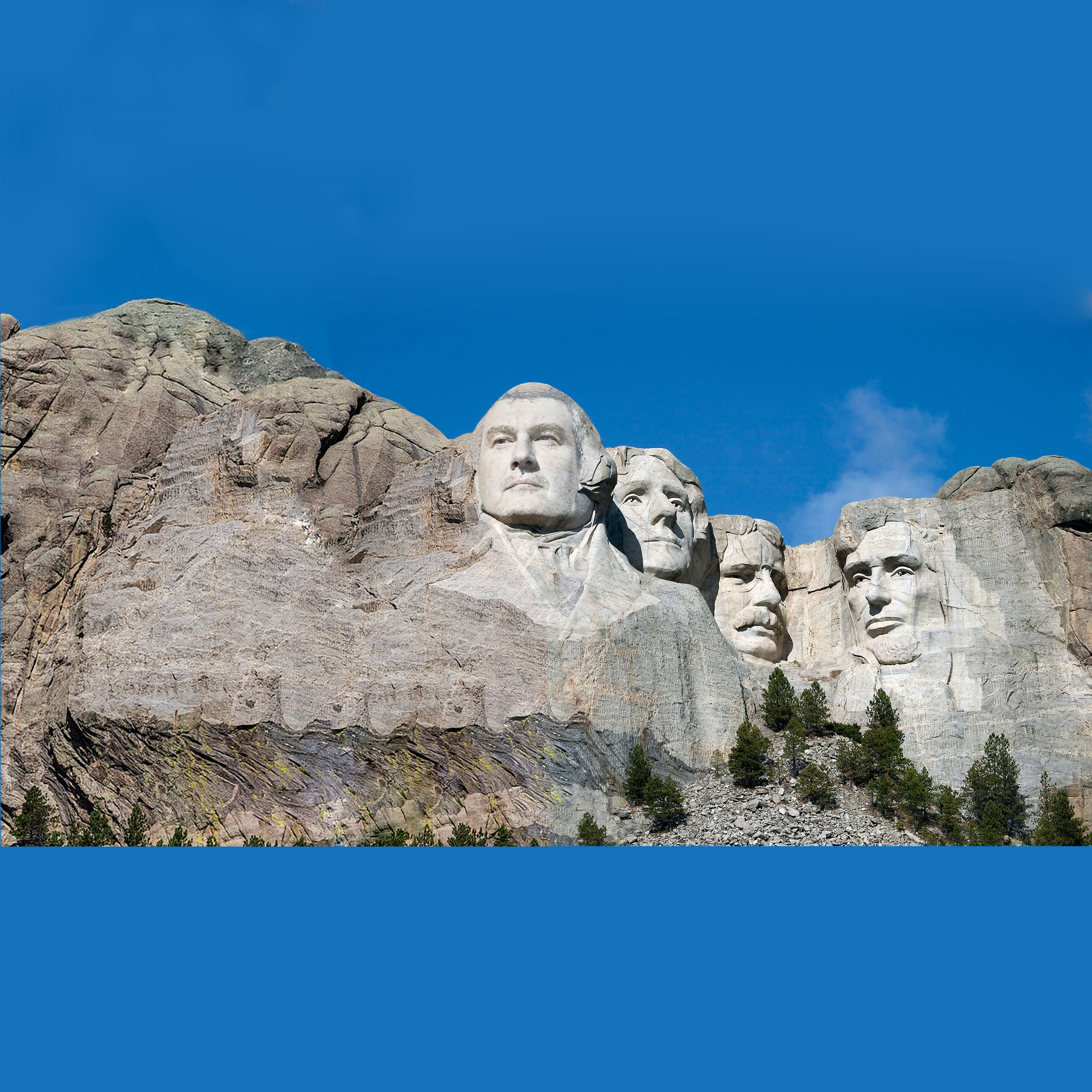

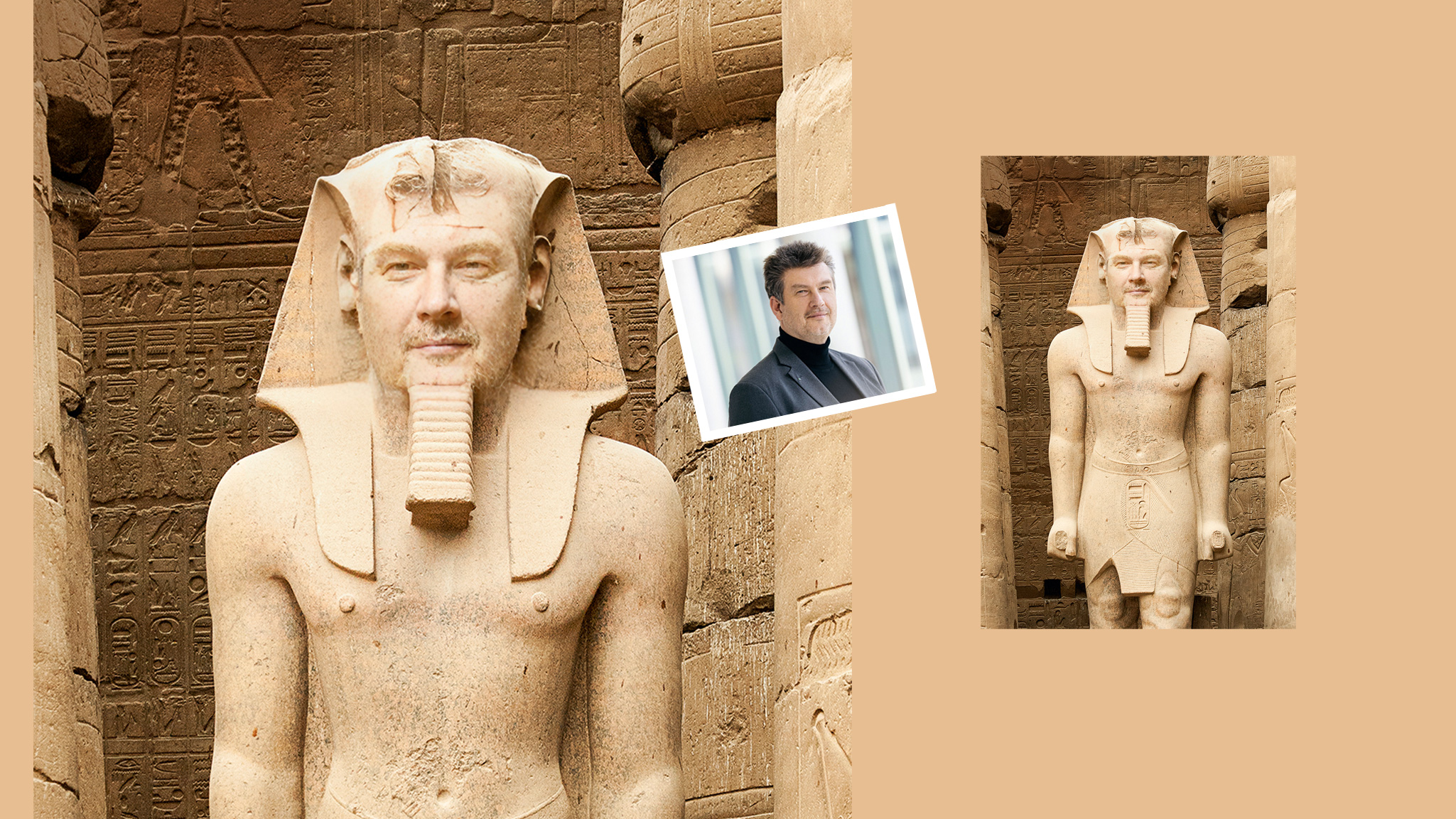

Die Methoden der Manipulation sind vielfältig: So werden beim Face Swapping zwei Gesichter aus unterschiedlichen Aufnahmen einfach ausgetauscht. Beim sogenannten Facial Reenactment spricht eine Person einen falschen Text ein und steuert eine Zielperson in einem echten Video mit ihren Bewegungen und Gesten fern – in Echtzeit. »Neu ist die Möglichkeit, mit Voice Cloning und Lippensynchronisation überzeugende Videos beliebiger Inhalte zu erstellen«, weiß Prof. Martin Steinebach, der Forensik-Experte vom Fraunhofer SIT: »Dazu werden existierende Videos einfach mit einer KI-generierten gefälschten Tonspur hinterlegt und die Lippenbewegungen daran angepasst.«

Um derart manipulierte Bilder oder Videos zu erkennen, setzt das Team um Steinebach auf eine Kombination aus Deep Learning und klassischer Signalverarbeitung. Mit Letzterer lassen sich weichgezeichnete oder leicht verwaschene Strukturen in einem Bild erkennen, die typisch für Deepfakes sind. »Wir messen die Frequenzanteile von bestimmten Bildausschnitten und vergleichen sie mit anderen Teilen etwa im Hintergrund. Zeigen sich Abweichungen, kann das ein Indiz für eine Fälschung sein.« Da Deepfakes immer nur einen Bereich in echten Videos austauschen, hat dieser Bereich auch abweichende statistische Eigenschaften. Diese lassen sich mit einer tiefergehenden Pixelanalyse erkennen. Wird nicht das Video selbst, sondern nur die Tonspur verändert, lassen sich bereits bekannte Aufnahmen oft leicht mit inversen Bildersuchen wiederfinden. Dabei sind vor allem die gleiche Gestik, aber abweichende Lippenbewegungen verräterisch.

Vorsicht bei automatischen Detektoren

Zwar sind heute bereits einige KI-basierte Erkennungstools auf dem Markt, die einfache und billige technische Lösungen versprechen. Doch wie realistisch ist die Wahrheit auf Knopfdruck? Steinebach warnt davor, sich in Videokonferenzen oder Browsern auf Online-Detektoren zu verlassen. »Dazu sind die Fehlerraten noch zu hoch und es würde mehr verunsichern als nützen, wenn ständig Warnungen kämen.« Vielmehr plädiert er dafür, solche Lösungen nur in Verbindung mit mehreren geschulten Expertenaugen einzusetzen. Forensische Gutachten, in die weitere Faktoren wie Quellen, Fälschungsszenarien, Plausibilitätsprüfungen oder etwaige Umgehungsstrategien mit einfließen, bieten eine wesentlich höhere Sicherheit. Wegen ihrer Kosten werden solche Analysen jedoch meist nur in besonders sicherheitskritischen oder rechtlich relevanten Bereichen in Auftrag gegeben.

Wie sehr bei den meist noch zweistelligen Fehlerraten gängiger Detektoren Vorsicht geboten ist, dass sie gar missbraucht werden können, verdeutlicht folgendes Beispiel: Nach dem Angriff der Hamas auf Israel am 7. Oktober 2023 veröffentlichte die israelische Regierung mehrere Bilder verbrannter Babyleichen, um die Gräueltaten der Terroristen zu belegen. Bei einem der Fotos schlug ein Fake-Detektor fälschlicherweise an. Daraufhin generierten die Widersacher ein neues Bild mit KI, in dem sie die Kinder gegen tote Hunde austauschten, und das sie dann als Originalbild deklarierten. Auf diese Weise sollten auch alle anderen Beweisbilder, bei denen kein Detektor anschlug, als Fälschungen und die Israelis als Betrüger diskreditiert werden.

Auch das britische Königshaus musste im Frühjahr die Auswirkungen solcher Falsch-Positiv-Meldungen erfahren. Kaum machte bei einem Familienbild der Royals ein Online-Detektor Unregelmäßigkeiten aus, war der Skandal perfekt. Dass die gesamte Fachwelt nichts Verdächtiges fand und letztlich eine Standardbildbearbeitung, wie sie Hobbyfotografen oft machen, ausschlaggebend war, ging in der sich überschlagenden Berichterstattung fast unter.

Wenn die Detektion von Fälschungen noch derart fehlerbehaftet ist, hilft eine andere Methode, zumindest die Originale zu erkennen: »Die einzige Strategie, mit der man heute relativ sicher sein kann, ist eine Positiv-Signatur: Neuere Digitalkameras versehen ihre Bilder mit einer kryptografischen Signatur, die nur schwer zu fälschen ist. Auch entsprechende Handy-Apps sind verfügbar«, so Steinebach. »Zudem arbeiten große IT-Konzerne an neuen Sicherheitsstrategien, bei denen – ähnlich dem Blockchain-Konzept – zum Beispiel alle Verarbeitungsschritte eines Bildes signiert und gespeichert werden.« Diese Nachricht dürfte auch die britischen Royals freuen.